Témoignage crise de la quarantaine …

Le seul repère possible, celui du cœur Je ne peux vivre qu’au présent au

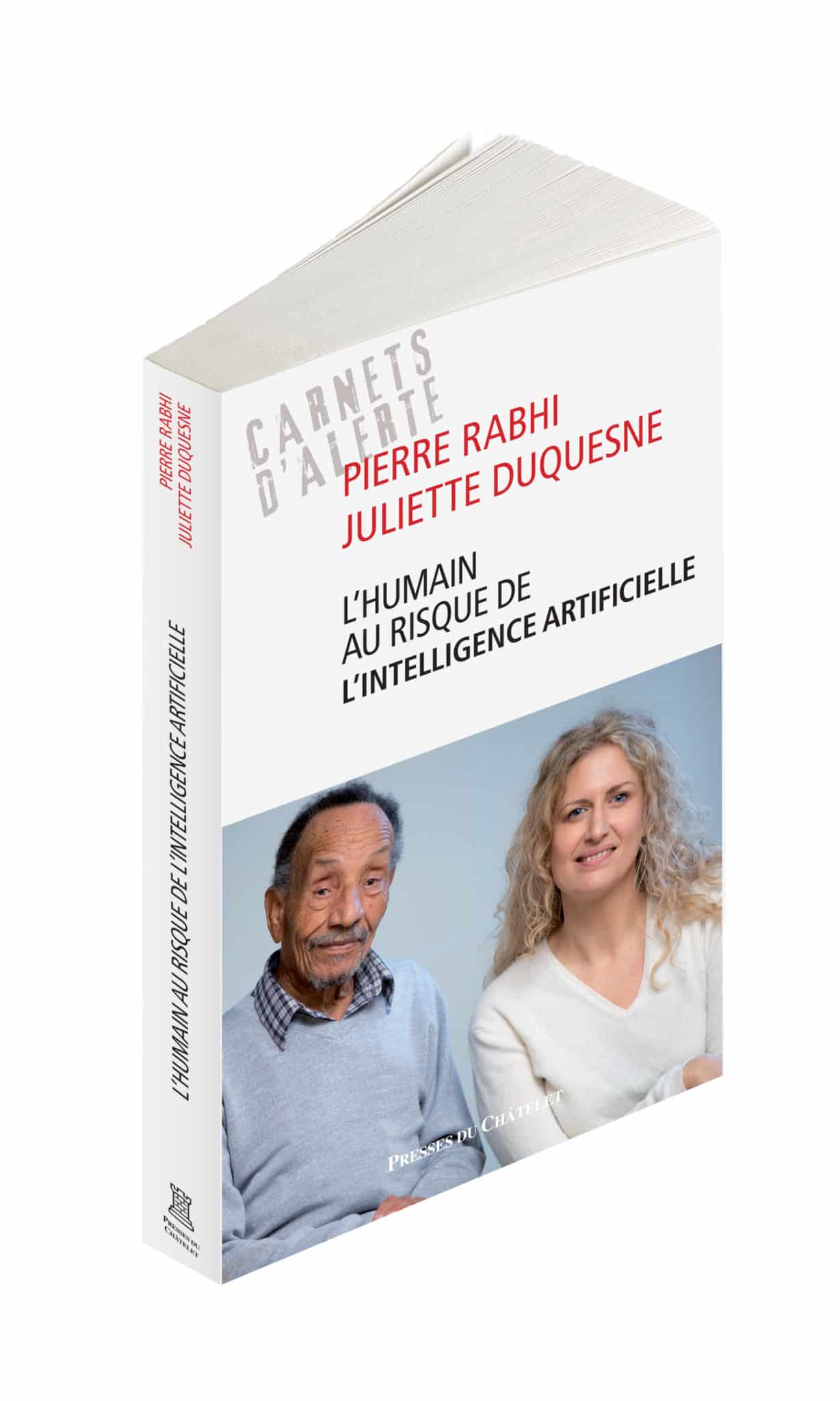

Journaliste indépendante spécialisée dans les thématiques environnementales et économiques. Elle a créé une collection de livres (avec Pierre Rabhi, les Presses du Châtelet) : Carnets d’alerte, et un média du même nom : www.carnetsdalerte.fr . Six livres ont déjà été publiés : Pour en finir avec la faim dans le monde, Les Semences, un patrimoine vital en voie de disparition, Les Excès de la finance ou l’art de la prédation légalisée, L’eau que nous sommes, Vivre mieux sans croissance, L’Humain au risque de l’intelligence artificielle. Chaque enquête dure plus d’un an : plus de 60 personnes interrogées, chaque chiffre sourcé. Auparavant, Juliette Duquesne a travaillé une dizaine d’années pour le journal de TF1. Pour en savoir plus : www.julietteduquesne.fr ; www.carnetsdalerte.fr

Il est difficile de répondre à cette question. La pollution du numérique est un risque majeur de l’intelligence artificielle. Aujourd’hui, c’est la fabrication des équipements (ordinateurs, téléphones, téléviseurs…) qui est la principale source de pollution dans le numérique (émissions de gaz à effet de serre, consommation d’eau et de métaux.) L’intelligence artificielle n’est pas directement concernée par ces équipements. Néanmoins, les réseaux sociaux, les nombreuses applications comme Waze, les enceintes connectées, les futures villes intelligentes ou les possibles voitures autonomes utilisent des programmes d’intelligence artificielle. Et c’est pour utiliser ces programmes au quotidien que nous achetons toujours plus d’équipements informatiques.

Un autre risque essentiel de l’intelligence artificielle : l’humain. Voilà d’ailleurs pourquoi nous avons décidé d’intituler notre ouvrage, l’Humain au risque de l’intelligence artificielle. Afin de fabriquer un programme d’IA, dans de nombreux cas, nous passons des mots aux nombres, nécessaires à la mise en données et en algorithmes, puis au codage informatique. Chaque étape schématise et fige la réalité. Les mots sont plus subtils que les nombres.

Malheureusement, ce n’est pas parce qu’une invention ne fonctionne pas ou mal que son utilisation s’arrête. Dans le secteur de la finance, on continue d’utiliser les multiples modèles algorithmiques en partie à l’origine de la crise des subprimes…

Même lorsqu’ils sont inefficients, ces modèles ont de nombreux effets sur nos vies. Ils rigidifient et rendent moins souples les interactions au sein de la société. Dans des secteurs tous les jours plus nombreux, nous échangeons avec des machines qui ne s’adaptent pas comme peuvent le faire des humains. Chacun doit entrer dans une case, sans considération de la situation et du cas particulier. Par conséquent, la principale crainte n’est pas d’être dominé par des machines, mais de simplifier nos comportements afin d’interagir avec un environnement où les programmes d’IA sont devenus légion. Cet appauvrissement est dénoncé depuis déjà plusieurs années par différents acteurs de la société civile comme le philosophe Jean-Michel Besnier.

Si cet article vous plait, pensez à faire un don. Le fonctionnement du site a un coût. Il n’y a pas de publicité.

Vous avez un bouton « don » sur le côté. Merci de votre participation quel que soit le montant

Utiliser ces programmes nécessite d’en connaître les limites. Nous pourrions très bien, comme le préconisent plusieurs chercheurs en intelligence artificielle, mettre en place des procédures de validation des algorithmes. Débattre -avant sa généralisation- de l’intérêt et des effets d’un programme d’IA paraît essentiel. Nombreux sont ceux à même réclamer des moratoires dans certains domaines comme la reconnaissance faciale ou l’analyse des sentiments.

Les algorithmes créés afin de mettre en avant la publicité, notamment par les Gafam, favorisent les fake news qui se répandent plus rapidement, nous maintiennent dans nos bulles de filtres et surfent sur les contenus colériques et clivants, beaucoup plus partagés. Il n’est pas toujours simple de distinguer ce qui provient de la construction de l’algorithme de ce qui vient de nos comportements et de nos préférences. Les algorithmes accentuent et amplifient des comportements déjà présents.

Les fake news ont environ deux fois plus de chances d’être relayées sur Twitter et le sont six fois plus rapidement. Les posts exprimant la colère dominent souvent les réseaux sociaux. Une étude chinoise montre que ceux qui relaient la colère se propagent plus rapidement sur un réseau social semblable à celui de Twitter.

Autre élément qui pollue nos démocraties : cette surveillance par les Gafam ou par les États encourage une paranoïa généralisée de la population. Les citoyens ne savent pas où et par quel biais, leurs données ou leurs comportements sont surveillés. Cette paranoïa fragilise grandement nos démocraties. Je ne sais pas si les Gafam supplantent la démocratie, en tout cas, ces multinationales la déstabilisent.

Pour lire l’article REFLETS n°42 pages 8 à 10

Le seul repère possible, celui du cœur Je ne peux vivre qu’au présent au

La crise de la quarantaine est le plus souvent inaperçue ou perçue comme négative. Pourtant

Voici un inédit de Gitta Mallasz sur le jeu publié seulement dans les Cahiers

Journaliste indépendante spécialisée dans les thématiques environnementales et économiques. Elle a créé une collection de livres (avec Pierre Rabhi, les Presses du Châtelet) : Carnets d’alerte, et un média du même nom : www.carnetsdalerte.fr .

La méthode Reflets, expérimentée depuis 2012 pour écrire les articles de la revue, est l’outil utilisé pour passer de l’écriture émotionnelle à l’écriture inspirée.

Révélez votre génialité

REFLETS, revue trimestrielle, porte un autre regard sur l’actualité essayant d’apercevoir ce qui se joue au-delà de l’aspect émotionnel, pour la société, la civilisation, voire l’Histoire.

Le site Reflets est destiné à devenir un lieu d’échange où chaque internaute peut trouver gratuitement :

Et cela sans avoir :

De ce fait, pour que Reflets puisse perdurer, nous vous invitons à faire un don à l’association.

De quelques centimes à ….illimité, c’est vous qui choisissez.